ChatGPT 開發商 OpenAI 週一發佈最新的人工安全智慧指南,解釋該公司將如何為 OpenAI 最先進、未發布的 AI 模型進行評估,以預防潛在的災難性風險。

(前情提要:拜登簽署首份AI行政命令!加強監管「人工智慧」國安危險)

(背景補充:巴菲特憂 AI 如原子彈危險:我們無法取消他的發明!查理芒格懷疑是炒作)

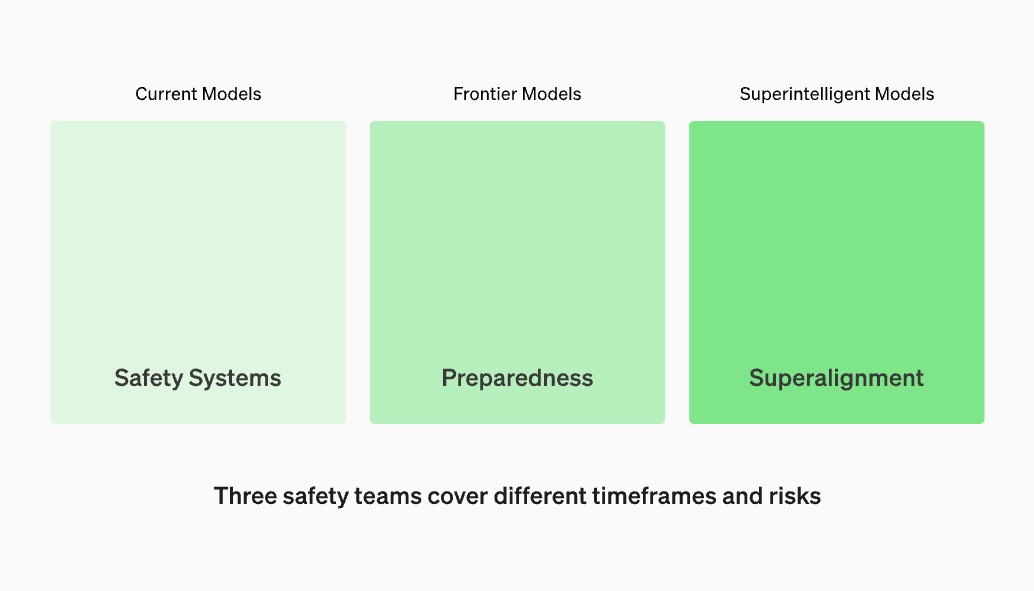

火爆全球的聊天機器人 ChatGPT 開發商 OpenAI,18 日公布最新的人工智慧安全指南,這一框架被稱作「準備框架(Preparedness Framework)」,由該公司的三個獨立安全團隊之一的準備團隊所提出。

OpenAI提出AI安全評估框架,防範災難性風險

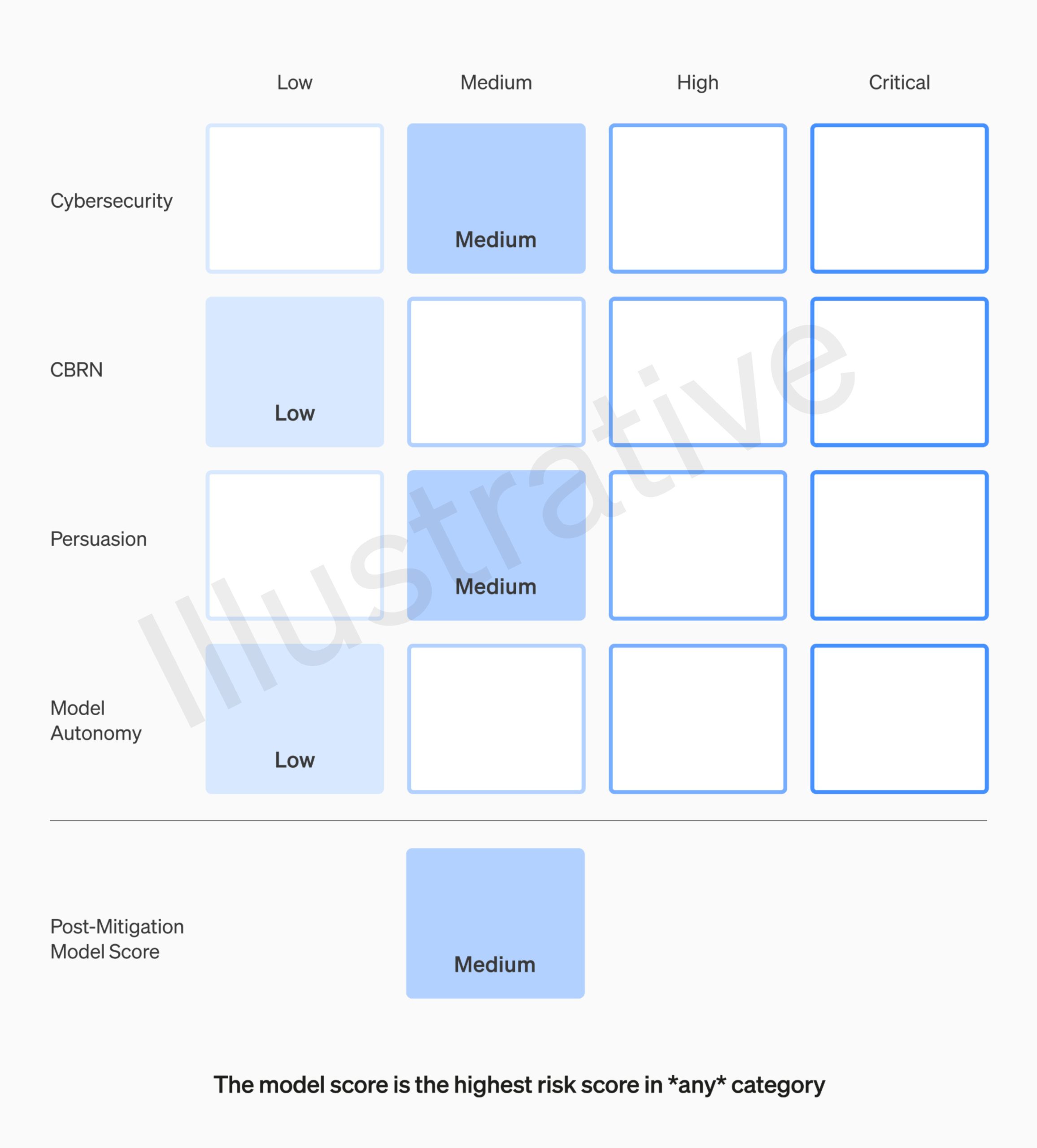

綜合華盛頓郵報、海峽時報報導,準備團隊將評估前沿的人工智慧系統可能帶來的「災難性風險」,在該份框架中災難性風險被定義為「可能導致數千億美元經濟損失或許多人受到嚴重傷害或死亡的任何風險」。並將根據四個類別為模型進行評分:

- 網路安全風險(Cybersecurity)

- 化生放核等大規模殺傷性武器(CBRN)

- AI 說服和欺騙人類的能力(Persuasion)

- AI S8自主性(Model Autonomy)

延伸閱讀:Sam Altman被奪權真正原因?OpenAI董事會收到警告:新AI威脅全人類

董事會有權阻止新模型推出

OpenAI 的「準備」團隊,由麻省理工學院 AI 教授 Aleksander Madry 領導,將反覆評估 OpenAI 最先進、未發布的 AI 模型,Open AI 僅能推出緩解後風險評級為中或低的模型。

OpenAI 還將聘請AI 研究員、電腦科學家、國家安全和政策專家來組成安全諮詢小組,準備團隊將向該小組每月提交報告,而該小組則將向公司領導層和董事會提出建議。

值得注意的是,儘管 Open AI 執行長 Sam Altman 等領導層對是否推出 AI 模型擁有決策權,但董事會也有權推翻決定,選擇推遲發佈 AI 模型。此外,準備團隊還計畫定期進行安全演習,對一些安全問題進行壓力測試,並將允許合格、獨立的第三方進行審核。

準備團隊的領導人 Madry 教授表示,他希望其他公司也能使用 OpenAI 的指南來評估其 AI 模型的潛在風險。

「我確實認為這種加速和減速的框架極其簡單化。人工智慧有很多優點,但我們還需要努力確保其優點真正被實現,而缺點沒有被實現。」

📍相關報導📍

歐盟通過重大AI法案!ChatGPT、大型語言模型、人臉辨識..都要監管